Trên Church Life Journal của Đại học Notre Dame, ngày 15 tháng 8 năm 2025, Taylor Black (*) có bài viết về trí tuệ nhân tạo (AI). Ông viết:

Vào một buổi chiều muộn tại Detroit, một người đàn ông tên Robert Williams đã bị bắt ngay trên bãi cỏ trước nhà, trước sự kinh hoàng của gia đình. Anh ta bị đưa vào tù và bị giam giữ gần ba mươi giờ vì một vụ trộm mà anh ta không hề thực hiện—tất cả chỉ vì một AI nhận dạng khuôn mặt tuyên bố anh ta là thủ phạm.[1] Chỉ có một vấn đề: Trí tuệ nhân tạo đã sai. Hình ảnh giám sát bị mờ, và ngoài việc là những người đàn ông Mỹ gốc Phi có vóc dáng tương tự, Robert và nghi phạm thực sự trông không giống nhau chút nào. Robert sau đó than thở: “Làm sao có thể giải thích cho hai cô bé rằng một chiếc máy tính đã sai, nhưng cảnh sát vẫn lắng nghe nó?”. Các con gái của ông đã chứng kiến người cha vô tội của mình bị còng tay do lỗi của một chiếc máy, một lỗi đã để lại vết sẹo vĩnh viễn về sự bất công trong gia đình.

Biến cố có thật này minh họa rõ nét những rủi ro về mặt đạo đức khi sử dụng trí tuệ nhân tạo trong một số lĩnh vực nhất định. Khi các hệ thống trí tuệ nhân tạo âm thầm len lỏi vào cuộc sống hàng ngày—từ các thuật toán quản lý nguồn cấp tin tức đến tự động hóa hướng dẫn quyết định tuyển dụng và giám sát—mỗi hệ thống đều hứa hẹn hiệu quả và hiểu biết sâu sắc, nhưng cũng tiềm ẩn rủi ro dẫn đến những hậu quả không mong muốn. Một vụ bắt giữ sai trái, việc phê duyệt khoản vay thiên vị, hay một bong bóng mạng xã hội bị bóp méo có thể đảo lộn cuộc sống và làm xói mòn niềm tin. Chúng ta ứng phó với những thách thức như vậy như thế nào? Làm thế nào chúng ta có thể đảm bảo những Kỹ thuật mạnh mẽ này phục vụ công lý và lợi ích chung, thay vì phá hoại chúng? Chúng ta cần nhiều hơn những giải pháp kỹ thuật; chúng ta cần sự khôn ngoan và sáng suốt về mặt đạo đức.

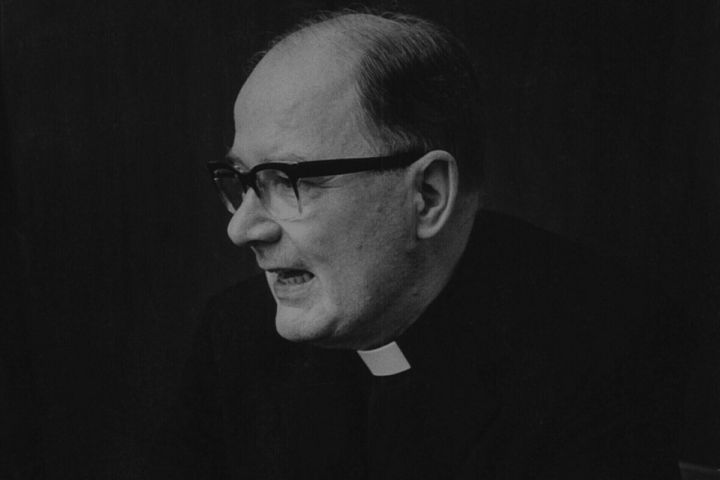

Trong hành trình tìm kiếm sự phân định đó, việc tìm đến một người dẫn đường bất ngờ sẽ rất hữu ích: triết gia và nhà thần học Dòng Tên thế kỷ 20, Bernard Lonergan. Lonergan được biết đến với việc nêu ra năm “giới luật siêu việt [transcendental precepts]” như những thói quen của tâm trí và trái tim để theo đuổi chân lý và lòng tốt: Hãy ý tứ, hãy thông minh, hãy hữu lý, hãy có trách nhiệm và hãy yêu thương.[2] Những nguyên tắc này ban đầu được xây dựng để mô tả cách con người chân thực đến với việc biết và quyết định, bắt nguồn từ điều mà Lonergan gọi là “mong muốn hiểu biết không giới hạn” của chúng ta – một động lực do Thiên Chúa ban tặng hướng tới chân lý và giá trị. Mặc dù ông sống rất lâu trước khi Trí tuệ nhân tạo hiện đại ra đời, những hiểu biết sâu sắc của Lonergan cung cấp một la bàn vô cùng hữu ích để định hướng những phức tạp về đạo đức của thời đại Trí tuệ nhân tạo.[3] Mỗi nguyên tắc cung cấp một lăng kính mà qua đó chúng ta có thể xem xét tương tác của mình với Trí tuệ nhân tạo: từ những gì chúng ta nhận thấy, đến cách chúng ta suy nghĩ, phán đoán, hành động và cuối cùng là tình yêu trong một thế giới ngày càng được định hình bởi các thuật toán.

Tiếp theo là một hành trình tường thuật qua năm nguyên tắc này được áp dụng vào cuộc gặp gỡ hiện đại của chúng ta với Trí tuệ nhân tạo. Bằng cách ý tứ đến cách Trí tuệ nhân tạo định hình trải nghiệm của chúng ta, thông minh về khả năng và giới hạn của nó, cân nhắc hữu lý những lời hứa của nó so với những nguy cơ, có trách nhiệm trong cách chúng ta thiết kế và sử dụng nó, và yêu thương trong việc đảm bảo nó phục vụ phẩm giá con người, chúng ta có thể vạch ra một con đường vừa am hiểu Kỹ thuật vừa vững chắc về mặt đạo đức. Khi làm như vậy, chúng ta đáp lại lời kêu gọi cấp bách để dẫn dắt Trí tuệ nhân tạo bằng trí tuệ của con người, thay vì bị Trí tuệ nhân tạo dẫn dắt mà không suy tư.

Những nguyên tắc của Lonergan trong thời đại Trí tuệ nhân tạo

Năm nguyên tắc của Lonergan tạo thành một chuỗi các bước để nhận thức đạo đức, giúp chúng ta vững vàng giữa những bước tiến nhanh chóng của Trí tuệ nhân tạo.[4] Chúng đi từ quan sát đến hiểu biết, đến phán đoán, hành động và cuối cùng là định hướng hướng đến điều tốt đẹp. Được đan xen vào một câu chuyện, những nguyên tắc này có thể thay đổi cách chúng ta tiếp cận những cuộc gặp gỡ hàng ngày với máy móc thông minh. Hãy cùng xem xét từng nguyên tắc và ý nghĩa của chúng đối với thời đại Trí tuệ nhân tạo.

Hãy ý tứ

Hãy ý tứ đến những gì thực sự hiện hữu. Nguyên tắc đầu tiên này thúc giục chúng ta ý tứ đến trải nghiệm của mình một cách có ý thức, chủ động nhận thức thay vì trôi dạt một cách thụ động. Trong bối cảnh Trí tuệ nhân tạo, ý tứ có nghĩa là nhận ra cách nhận thức của chúng ta về thế giới ngày càng được điều chỉnh bởi các thuật toán – thường theo những cách tinh tế mà chúng ta hầu như không nhận thấy.

Hãy xem xét hành động đơn giản là đọc tin tức. Nhiều người trong chúng ta lướt qua các nguồn cấp dữ liệu trên Facebook, Twitter hoặc Google News, tin rằng chúng ta đang xem một phần lớn các biến cố hiện thời. Trên thực tế, các thuật toán Trí tuệ nhân tạo tinh vi đang tuyển chọn những gì chúng ta thấy, lựa chọn các câu chuyện dựa trên các lần nhấp chuột, vị trí và hồ sơ trước đây của chúng ta. Theo thời gian, sự cá nhân hóa này có thể bọc chúng ta trong một cái kén vô hình của nội dung cùng chí hướng, một bong bóng sàng lọc [filter bubble] củng cố thành kiến của chúng ta. “Nếu thuật toán chỉ hiển thị cho bạn những tin tức mà nó nghĩ rằng bạn sẽ thích... bạn có thể không biết rằng những quan điểm khác quan điểm này thậm chí có tồn tại hay không”, một nhà khoa học máy tính đã cảnh báo như thế; nhà khoa học này lưu ý rằng vì tất cả đều được thực hiện “đằng sau hậu trường”, chúng ta hầu như không nhận thấy chế độ ăn uống thông tin của mình đang bị thu hẹp.[5] Nếu không ý tứ, chúng ta có thể sống dưới sự chi phối của các ưu tiên thuật toán, nhầm lẫn một góc nhìn cục bộ với toàn bộ sự thật.

Do đó, việc ý tứ trong thời đại Trí tuệ nhân tạo đòi hỏi một loại chánh niệm kỹ thuật số [digital mindfulness]. Chúng ta phải tự hỏi: Trợ lý thông minh của tôi không nói với tôi điều gì? Những giọng nói nào có thể bị thiếu trong nguồn cấp dữ liệu mạng xã hội của tôi? Các hệ thống Trí tuệ nhân tạo đang định hình nhận thức của tôi về thực tại như thế nào? Điều này có thể có nghĩa là nhận thấy rằng sau khi xem một video trên YouTube, các gợi ý “Tiếp theo” bắt đầu kéo chúng ta vào một con đường cực đoan hơn hoặc nhận ra rằng “tuyến đường nhanh nhất” của ứng dụng dẫn đường thực chất đang thu thập dữ liệu giao thông từ chúng ta. Điều này có nghĩa là phải ý tứ đến những sai lệch tiềm ẩn trong xuất lượng [output] của Trí tuệ nhân tạo—chẳng hạn như khi ứng dụng nhận dạng hình ảnh liên tục gặp khó khăn với những khuôn mặt có làn da sẫm màu, hoặc khi một gợi ý tự động hoàn thành có vẻ mang tính định kiến. Tóm lại, “Hãy Ý tứ” kêu gọi chúng ta luôn tỉnh táo với những gì Trí tuệ nhân tạo đang làm xung quanh và với chính chúng ta. Chỉ bằng cách nhìn nhận rõ ràng, chúng ta mới có thể hy vọng phản ứng một cách chính đáng.

Hãy Thông Minh

Tiếp theo là sự hiểu biết. Thông minh nghĩa là đi sâu vào lý do và cách thức—tìm kiếm sự thấu hiểu, tạo kết nối, tiếp thu kiến thức. Lời kêu gọi trở nên thông minh của Lonergan mời gọi chúng ta vượt ra khỏi những ấn tượng bề ngoài và đặt ra những câu hỏi sâu sắc hơn về các hệ thống Trí tuệ nhân tạo: Chúng hoạt động như thế nào? Giới hạn của chúng là gì? Chúng được xây dựng dựa trên những giả định nào?

Trong thực tế, điều này có thể bao gồm việc tìm hiểu một số kiến thức cơ bản về Trí tuệ nhân tạo. Ví dụ, hầu hết các thuật toán Trí tuệ nhân tạo học hỏi từ dữ liệu lịch sử. Điều đó có nghĩa là nếu dữ liệu bị sai lệch hoặc có định kiến, “trí thông minh” của Trí tuệ nhân tạo sẽ thừa hưởng những sai sót đó. Một ví dụ điển hình xuất hiện vài năm trước khi Amazon phát triển một Trí tuệ nhân tạo thử nghiệm để hữu lý hóa quy trình tuyển dụng. Mục tiêu là tạo ra một chương trình sàng lọc sơ yếu lý lịch và xác định những ứng viên hàng đầu. Nhưng dự án đã gặp phải một trở ngại: đến năm 2015, các kỹ sư nhận ra Trí tuệ nhân tạo đang xếp hạng các ứng viên một cách rõ ràng là không công bằng đối với phụ nữ.[6] Tại sao? Thuật toán đã tự đào tạo dựa trên hồ sơ xin việc trong mười năm, hầu hết đến từ nam giới (phản ảnh sự thống trị của nam giới trong ngành Kỹ thuật). Trên thực tế, cỗ máy đã kết luận rằng nam giới là điều kiện tiên quyết để trở thành một kỹ sư giỏi. Nó bắt đầu hạ cấp các sơ yếu lý lịch có đề cập đến “phụ nữ” (như trong “đội trưởng câu lạc bộ cờ vua nữ”) hoặc đến từ các trường đại học nữ.

Trí tuệ nhân tạo đã làm chính xác những gì nó được dạy – tìm kiếm các mô hình trong dữ liệu – nhưng nó thiếu hiểu biết để biết rằng những mô hình đó đang phản ảnh sự thiên vị trong quá khứ chứ không phải thành tích trong tương lai. Amazon đã khôn ngoan loại bỏ công cụ đó khi những điểm mù của nó trở nên rõ ràng. Câu chuyện cảnh báo này nhấn mạnh lý do tại sao việc hiểu biết về Trí tuệ nhân tạo là điều cần thiết. Chúng ta phải nỗ lực tìm hiểu tiềm năng cũng như giới hạn của một hệ thống Trí tuệ nhân tạo. Đúng vậy, Trí tuệ nhân tạo có thể phát hiện các mẫu hình trong các tập dữ liệu khổng lồ vượt xa khả năng của con người, mang lại những hiểu biết hữu ích – từ việc phát hiện các dấu hiệu ban đầu của bệnh tật trong các lần chụp chiếu [scan] y tế đến dự đoán thảm họa thời tiết. Nhưng Trí tuệ nhân tạo không phải là phép thuật, cũng không phải là bất khả xâm phạm. Nó không thực sự “hiểu” bối cảnh hay ý nghĩa; nó tìm kiếm mối tương quan, chứ không phải nguyên nhân. Và nó sẽ khuếch đại một cách trung thực bất cứ điều gì được nhúng vào quá trình đào tạo của nó.

Ví dụ, trong lĩnh vực thực thi pháp luật, một số thành phố đã áp dụng các thuật toán dự đoán cảnh sát với hy vọng giảm tội phạm bằng cách phân bổ lực lượng tuần tra của cảnh sát dựa trên số liệu thống kê tội phạm. Trên thực tế, những công cụ này thường dẫn đến việc duy trì định kiến chủng tộc. Họ đã cử cảnh sát đến cùng một khu dân cư được giám sát quá mức hết lần này đến lần khác, bởi vì bản thân dữ liệu lịch sử đã bị bóp méo bởi hàng thập niên giám sát không cân xứng trong các cộng đồng thiểu số.[7] Kết quả có thể là một vòng luẩn quẩn: càng nhiều cuộc tuần tra thì càng có nhiều vụ việc được ghi nhận, điều này lại biện minh cho việc tăng thêm các cuộc tuần tra, trong khi lại nhắm mục tiêu một cách không công bằng vào người da màu.

Một cách tiếp cận thông minh sẽ nhận ra cạm bẫy này. Điều này đòi hỏi sự minh bạch về cách Trí tuệ nhân tạo đưa ra quyết định và sự cảnh giác về chất lượng dữ liệu của nó. Nó cũng có nghĩa là thừa nhận những gì Trí tuệ nhân tạo không thể làm: nó không thể đánh giá giá trị, đạo đức, hay toàn bộ tính độc đáo của một tình huống con người. Trở nên thông minh không phải là sở hữu tất cả kiến thức kỹ thuật, mà là trau dồi sự hiểu biết thận trọng về khả năng và điểm yếu của Trí tuệ nhân tạo. Theo Lonergan, đó là sự khác biệt giữa dữ liệu thô và hiểu biết có ý nghĩa. Chúng ta cần hiểu biết đó để sử dụng Trí tuệ nhân tạo một cách khôn ngoan.

Hãy Hữu Lý

Chỉ kiến thức thôi là chưa đủ; chúng ta phải đánh giá xem nên làm gì với nó. Hữu lý nghĩa là áp dụng đánh giá phê phán và phán đoán đúng đắn vào những hiểu biết mà chúng ta đã có được. Nó bao gồm việc đặt câu hỏi: Điều này có đúng không? Điều này có tốt không? Và cân nhắc các lựa chọn dựa trên bằng chứng và các nguyên tắc đạo đức. Trong một thế giới bão hòa Trí tuệ nhân tạo, việc hữu lý đòi hỏi chúng ta phải sàng lọc những lời cường điệu và nỗi sợ hãi xung quanh Kỹ thuật và đánh giá vai trò của Trí tuệ nhân tạo với sự trung thực và minh bạch về mặt đạo đức.

Một khía cạnh của sự hữu lý là cân nhắc về những đánh đổi và hậu quả của Trí tuệ nhân tạo. Việc chúng ta có thể làm điều gì đó với Trí tuệ nhân tạo không có nghĩa là chúng ta nên làm. Ví dụ, các bộ lọc nội dung do Trí tuệ nhân tạo điều khiển trên mạng xã hội có thể chặn tuyên truyền cực đoan và ngôn từ kích động thù địch—nhưng chúng cũng có thể vô tình kiểm duyệt các cuộc thảo luận chính đáng hoặc biểu đạt nghệ thuật. Liệu sự đánh đổi này có đáng không? Tương tự, việc trang bị Trí tuệ nhân tạo cho máy bay không người lái hoặc vũ khí tự động có thể bảo vệ binh lính của chúng ta trong chiến đấu, nhưng rủi ro sai sót hoặc cái giá phải trả về mặt đạo đức của việc giao phó các quyết định sinh tử cho máy móc là gì? Hoặc hãy tưởng tượng một chiếc xe tự lái đối diện với một tình huống tai nạn bất khả: liệu nó có nên đánh chệch lái để tránh một người đi bộ nếu làm như vậy sẽ gây nguy hiểm cho hành khách? Không có thuật toán đơn giản nào cho những tình huống khó xử về mặt đạo đức như vậy; chúng buộc chúng ta phải làm rõ các giá trị và ưu tiên của con người. Một cách tiếp cận hữu lý không để những câu hỏi này chỉ dành cho các kỹ sư; nó khẳng định rằng các nhà đạo đức học, triết gia và cộng đồng có tiếng nói khi cân nhắc lợi ích và tác hại.

Hữu lý cũng có nghĩa là phê phán những câu chuyện lớn thường đi kèm với Kỹ thuật mới. Một trong những câu chuyện như vậy là huyền thoại định mệnh thuyết Kỹ thuật [technological determinism]- quan điểm cho rằng sự tiến bộ của Trí tuệ nhân tạo là tất yếu và về cơ bản nằm ngoài tầm kiểm soát của chúng ta. Quan điểm này, đôi khi được khuyến khích (ngầm hoặc công khai) bởi những người có tầm nhìn xa của Big Tech, có thể ru ngủ xã hội vào sự chấp nhận thụ động bất cứ điều gì Thung lũng Silicon mang lại.[8] Nếu “cuộc cách mạng Trí tuệ nhân tạo” là không thể ngăn cản, tại sao lại phải bận tâm đặt câu hỏi về nó? Nhưng khuôn khổ của Lonergan thúc giục chúng ta bác bỏ thuyết định mệnh đó.

Máy móc không chỉ tự biến hóa; con người thiết kế, đào tạo và triển khai chúng. Tương lai của Trí tuệ nhân tạo sẽ được định hình bởi những lựa chọn và giá trị của con người, cho dù chúng ta có thừa nhận điều đó hay không. Lý trí đòi hỏi chúng ta phải giành lại quyền tự quyết của mình. Chúng ta nên xem xét kỹ lưỡng những tuyên bố táo bạo (ví dụ, Trí tuệ nhân tạo sẽ sớm vượt qua trí thông minh của con người trong mọi lĩnh vực) và phân biệt tiến bộ thực tế với khoa học viễn tưởng hay chiêu trò tiếp thị. Chúng ta cũng nên lưu ý đến những hạn chế nội tại của Trí tuệ nhân tạo: dù tinh vi đến đâu, Trí tuệ nhân tạo vẫn thiếu nhận thức về bản thân, sự tương cảm và định hướng bẩm sinh hướng tới chân lý và lòng tốt mà con người sở hữu.[9]

Nói cách khác, dù Trí tuệ nhân tạo có vẻ “thông minh” đến đâu, nó cũng không phải là một tác nhân đạo đức. Hữu lý giúp chúng ta tránh gán cho Trí tuệ nhân tạo quá nhiều trí tuệ hay thẩm quyền hơn mức nó xứng đáng. Nó giúp chúng ta tập trung vào chân lý cơ bản rằng chúng ta chịu trách nhiệm về các công cụ mình tạo ra. Tư thế phê phán, tìm kiếm chân lý này rất quan trọng nếu chúng ta muốn định hướng Kỹ thuật hướng tới tiến bộ thực sự và tránh bị cuốn vào sự nhiệt tình thiếu khảo chứng.

Hãy có trách nhiệm

Với kiến thức được soi sáng bởi lý trí, nguyên tắc thứ tư của Lonergan kêu gọi chúng ta phải có trách nhiệm - hành động theo phán đoán tốt nhất của mình về điều gì là đúng. Trong bối cảnh này, trách nhiệm có hai ý nghĩa: nó nói với những người thiết kế và triển khai hệ thống Trí tuệ nhân tạo, và nói với tất cả chúng ta, những người sử dụng hoặc bị ảnh hưởng bởi chúng. Nó nhắc nhở chúng ta rằng đạo đức cuối cùng là về các quyết định và hành động cụ thể, chứ không chỉ là những nguyên tắc trừu tượng.

Đối với các nhà thiết kế và phát triển Trí tuệ nhân tạo, có trách nhiệm có nghĩa là xây dựng các hệ thống một cách có ý thức phù hợp với các giá trị đạo đức và phục vụ lợi ích chung. Điều này có thể bao gồm việc tuân theo các phương pháp hay nhất mới nổi cho thiết kế "Trí tuệ nhân tạo hợp đạo đức": kiểm tra các thuật toán để phát hiện thiên vị, đảm bảo tính minh bạch về cách đưa ra quyết định và bao gồm các ý kiến đa dạng trong quá trình phát triển. Nó cũng có nghĩa là chống lại áp lực phải vội vàng đưa sản phẩm ra thị trường mà không kiểm tra an toàn đầy đủ. Ví dụ, nếu một công ty Kỹ thuật đang phát triển phần mềm nhận dạng khuôn mặt, một cách tiếp cận có trách nhiệm có thể bao gồm việc đặt ra các tiêu chuẩn chính xác nghiêm ngặt cho các nhóm nhân khẩu học khác nhau trước khi triển khai, và thậm chí lựa chọn không bán sản phẩm cho một số người dùng cuối cùng [end user] nào đó (như các cơ quan chính phủ có hồ sơ nhân quyền kém). Điều quan trọng là các nhà phát triển thừa nhận trách nhiệm của họ đối với tác động xã hội của những sáng tạo của họ.[10] Họ không thể chỉ nói "thuật toán đã quyết định" như thể điều đó sẽ giải thoát họ—lập trình viên là người viết thuật toán, và dữ liệu mà thuật toán học hỏi được phản ảnh lịch sử con người. Do đó, trách nhiệm phải được "thiết kế sẵn" ngay từ đầu.

Đối với người dùng và công dân hàng ngày, việc có trách nhiệm với Trí tuệ nhân tạo có nghĩa là chịu trách nhiệm về cách chúng ta đưa những Kỹ thuật này vào cuộc sống của mình. Đó là về sự tham gia chủ động chứ không phải là sự tiêu thụ thụ động.[11] Trên thực tế, điều này có thể bao gồm các hành động và lựa chọn đơn giản, cùng nhau, định hướng việc sử dụng Trí tuệ nhân tạo theo hướng tốt hơn. Ví dụ:

• Đặt ra ranh giới cá nhân với Trí tuệ nhân tạo: hạn chế sự phụ thuộc của bạn vào các tiện ích Trí tuệ nhân tạo có thể gây nghiện hoặc xâm phạm. Một người dùng có trách nhiệm có thể quyết định tắt tính năng tự động phát thuật toán trên nền tảng video để tránh việc cuộn trang vô tận, hoặc lên lịch "ngày Sa-bát kỹ thuật số" thường xuyên để kiểm soát sự ý tứ của mình và không bị các thuật toán thao túng liên tục.

• Yêu cầu sự minh bạch và công bằng: hỗ trợ các công ty và sản phẩm minh bạch về hoạt động Trí tuệ nhân tạo của họ và ưu tiên quyền riêng tư của người dùng và đạo đức dữ liệu. Điều này có thể có nghĩa là sử dụng một công cụ tìm kiếm không theo dõi mọi hoạt động của bạn, hoặc chọn không sử dụng một ứng dụng yêu cầu quyền truy cập xâm phạm mà không có lý do chính đáng.

• Vận động và giáo dục: lãnh trách nhiệm cũng mở rộng ra phạm vi công cộng—tham gia vào các cuộc trò chuyện và tranh luận chính sách về Trí tuệ nhân tạo. Người ta có thể vận động cho các luật cấm sử dụng rõ ràng có hại (ví dụ: cấm sử dụng Trí tuệ nhân tạo thiên vị trong tuyển dụng hoặc kiểm soát) và ủng hộ các sáng kiến giám sát chặt chẽ việc triển khai Trí tuệ nhân tạo.[12] Tương tự như vậy, việc tự giáo dục bản thân và những người khác (trong gia đình, nhà thờ và cộng đồng của chúng ta) về cả lợi ích và rủi ro của Trí tuệ nhân tạo là một cách có trách nhiệm để xây dựng một xã hội hiểu biết hơn.

Mỗi hành động này phản ảnh nhận thức rằng chúng ta không phải là những khán giả bất lực của cuộc cách mạng Trí tuệ nhân tạo. Đúng hơn, chúng ta là người quản lý những công cụ mạnh mẽ này. Trong ngôn từ thần học, việc có trách nhiệm với Kỹ thuật là một phần trong ơn gọi của chúng ta, trở thành người quản lý tốt công trình sáng tạo - giờ đây được mở rộng để bao gồm cả những sáng tạo kỹ thuật số của trí tuệ con người. Cũng như chúng ta chịu trách nhiệm về cách chúng ta đối xử với môi trường hoặc với hàng xóm, chúng ta cũng chịu trách nhiệm về cách chúng ta "đối xử" với Trí tuệ nhân tạo (và cách Trí tuệ nhân tạo đối xử với người khác). Và điều này dẫn đến lời răn cuối cùng và tối hậu của Lonergan, điều mang lại ý nghĩa sâu sắc nhất cho tất cả những lời răn khác.

Hãy Yêu Thương

Lonergan thường mô tả lời răn thứ năm là "Hãy yêu thương", theo đó ông muốn nói đến một định hướng vô điều kiện hướng đến giá trị, lòng tốt, và cuối cùng là Thiên Chúa.[13] Yêu thương là đặt lòng bác ái vào trung tâm của mọi nhận thức và hành động của chúng ta. Không phải ngẫu nhiên mà những điều răn lớn nhất trong đức tin Kitô giáo là yêu Chúa và yêu người lân cận. Bất cứ đạo đức nào dừng lại ở trách nhiệm mà không vươn tới tình yêu thương sẽ vẫn lạnh lùng và không trọn vẹn. Tình yêu thương hoàn thiện và tôn vinh đời sống đạo đức, hướng nó đến sự tự hiến và lợi ích đích thực của người khác.

Đưa tình yêu thương vào mối quan hệ của chúng ta với Trí tuệ nhân tạo có nghĩa là gì? Điều đó có nghĩa là, trước hết và quan trọng nhất, hãy giữ gìn phẩm giá con người và lợi ích chung như kim chỉ nam của chúng ta. Hãy Yêu Thương nhắc nhở chúng ta rằng mọi quyết định kỹ thuật cuối cùng đều là quyết định về con người - về cách chúng ta tôn vinh hay làm mất hình ảnh của Chúa nơi người khác. Nếu một ứng dụng Trí tuệ nhân tạo, dù ấn tượng đến đâu, làm suy yếu phẩm giá con người hoặc cắt đứt kết nối giữa con người, thì tình yêu sẽ thôi thúc chúng ta đặt câu hỏi hoặc thậm chí từ chối nó. Ngược lại, nếu một Kỹ thuật có thể được khai thác để nâng đỡ con người, để chữa lành, để bao dung, để trao quyền cho những người bị thiệt thòi, thì tình yêu sẽ thúc đẩy chúng ta theo đuổi và hỗ trợ nó.

Ở bình diện bản thân, việc yêu thương trong thời đại kỹ thuật số có thể bao gồm những lựa chọn có chủ đích về vai trò của Kỹ thuật trong các mối quan hệ của chúng ta. Ví dụ, sử dụng Trí tuệ nhân tạo theo cách thúc đẩy cộng đồng thay vì cô lập. Điều này có thể đơn giản như tận dụng một ứng dụng nhắn tin để giữ liên lạc với gia đình ở xa (thay vì lướt web một mình), hoặc phức tạp như thiết kế các chương trình tiếp cận cộng đồng của nhà thờ sử dụng phân tích dữ liệu để phục vụ người nghèo tốt hơn. Nó cũng có nghĩa là cảnh giác trước những cách Trí tuệ nhân tạo có thể làm rạn nứt các mối quan hệ xã hội của chúng ta. Các thuật toán mạng xã hội thường ưu tiên các bài đăng gây ra phản ứng mạnh mẽ, có thể gieo rắc chia rẽ. Một cách tiếp cận yêu thương sẽ tìm cách khắc phục điều đó—có lẽ bằng cách chủ động tiếp cận ngoại tuyến với một người mà chúng ta bất đồng quan điểm, thay vì chỉ trích nhau trên Facebook. Nói cách khác, tình yêu nên định hình cách chúng ta sử dụng Kỹ thuật, chứ không phải ngược lại. Như một tài liệu gần đây của Vatican đã lưu ý, nếu Trí tuệ nhân tạo được sử dụng để giúp mọi người nuôi dưỡng những kết nối chân thành, nó có thể đóng góp tích cực cho sự phát triển của con người. Nhưng điều đó đòi hỏi một sự lựa chọn có ý thức đặt hạnh phúc của con người lên hàng đầu.

Ở bình diện đạo đức rộng hơn, Hãy Yêu Thương chuyển thành cam kết rằng Trí tuệ nhân tạo cuối cùng phải phục vụ những gì thực sự tốt đẹp cho nhân loại. Đức Giáo Hoàng Phanxicô đã nhiều lần nhấn mạnh điều này, kêu gọi sử dụng các Kỹ thuật mới theo cách thúc đẩy phẩm giá con người và lợi ích chung.[14] Tình yêu trong hành động có nghĩa là chúng ta đo lường thành công của Trí tuệ nhân tạo không chỉ bằng lợi nhuận hay hiệu quả, mà còn bằng cách nó tác động đến những người dễ bị tổn thương nhất trong chúng ta. Liệu một thuật toán ngân hàng có đối xử công bằng với người nghèo không? Liệu một hệ thống đề xuất nội dung có bảo vệ trẻ em khỏi bị tổn hại không? Liệu các tiện ích do Trí tuệ nhân tạo thúc đẩy của chúng ta có quan tâm đến những người có thể mất việc làm do tự động hóa không?

Một lăng kính tình yêu luôn hướng đến con người đằng sau điểm dữ liệu. Nó nhấn mạnh rằng con người là mục đích, không phải phương tiện, và Kỹ thuật nên là công cụ chăm sóc, chứ không phải là cái cớ để trốn tránh việc chăm sóc. Theo thuật ngữ Kitô giáo, nếu chúng ta tạo ra các hệ thống Trí tuệ nhân tạo giúp đỡ “những người bé mọn nhất” (Mt 25:40)—chẳng hạn như Trí tuệ nhân tạo chẩn đoán cho các bệnh viện chưa được phục vụ đầy đủ hoặc ứng dụng phiên dịch cho người tị nạn—thì chúng ta đang đi trên con đường của tình yêu. Nếu chúng ta làm ngược lại, cho phép Kỹ thuật hạ thấp giá trị hoặc bóc lột con người, chúng ta đã đánh mất cốt lõi nhân tính của chính mình.

Suy gẫm Thực tiễn và Thần học

Những nguyên tắc này có thể bén rễ như thế nào trong cộng đồng của chúng ta—đặc biệt là các cộng đồng đức tin của chúng ta? Nhiệm vụ hướng dẫn Trí tuệ nhân tạo về mặt đạo đức là quá lớn đối với bất cứ nhóm nào; nó đòi hỏi điều mà Đức Giáo Hoàng Phanxicô gọi là một cuộc đối thoại rộng rãi giữa những người tin và những người không tin về những vấn đề đạo đức cơ bản do Kỹ thuật đặt ra.[15] Giáo hội, với hai thiên niên kỷ khôn ngoan về bản chất con người, tội lỗi và ân sủng, có một vai trò quan trọng trong sự phân định văn hóa này. Nhưng Giáo hội phải làm điều đó một cách khiêm nhường và hợp tác, tìm hiểu về Kỹ thuật ngay cả khi nó tác động lên những hiểu biết thần học và đạo đức sâu sắc. Trước hết, các cộng đồng tôn giáo có thể nêu gương trong việc phân định việc sử dụng Trí tuệ nhân tạo. Cũng như các nhà thờ đã học cách đánh giá các phương tiện truyền thông như truyền hình hay internet một cách phê phán, Trí tuệ nhân tạo cũng vậy. Ví dụ, một giáo xứ có thể tổ chức một hội thảo về “Đời sống Kitô hữu trong thời đại kỹ thuật số”, giúp giáo dân suy gẫm về việc sử dụng điện thoại thông minh, thuật toán mạng xã hội và trợ lý Trí tuệ nhân tạo dưới góc độ đức tin của họ. Các mục tử và lãnh đạo mục vụ có thể khuyến khích các hoạt động chánh niệm: có thể đề xuất một buổi “xét mình Kỹ thuật” vào cuối ngày, nơi mọi người cùng cầu nguyện và suy gẫm về việc họ sử dụng các công cụ kỹ thuật số trong ngày hôm đó đã giúp họ gần gũi hơn hay xa rời Chúa và tha nhân hơn. Những suy tư như vậy đặt nền tảng cho hành động ý tứ, thông minh, hữu lý, v.v. trong bối cảnh tâm linh. Chúng cũng gửi đi một thông điệp: việc đặt câu hỏi về Kỹ thuật không phải là lạc hậu—mà là khôn ngoan.

Giáo hội có thể đóng góp vào việc định hình đạo đức công cộng và các chính sách về Trí tuệ nhân tạo. Truyền thống giáo huấn xã hội Công Giáo cung cấp một khuôn khổ phong phú (các nguyên tắc như công ích, nguyên tắc phụ đới, phẩm giá con người, ưu tiên chọn người nghèo) có thể định hướng hiệu quả cho đạo đức Kỹ thuật. Hãy lấy nguyên tắc công ích làm ví dụ: nó thúc giục chúng ta xem xét lợi ích của tất cả mọi người, đặc biệt là những người dễ bị tổn thương, trong bất cứ quyết định xã hội nào. Áp dụng vào Trí tuệ nhân tạo, điều này có thể có nghĩa là ủng hộ các quy định bảo vệ cộng đồng khỏi các quyết định có hại do Trí tuệ nhân tạo thúc đẩy hoặc thúc đẩy quyền tiếp cận công bằng với Trí tuệ nhân tạo có lợi (như sử dụng Trí tuệ nhân tạo trong y tế để phục vụ các khu vực nghèo đói, không chỉ người giàu).

Trong những năm gần đây, chính Vatican đã tham gia vào cuộc thảo luận này—đồng tài trợ cho Lời kêu gọi Rome về Đạo đức Trí tuệ nhân tạo và triệu tập các chuyên gia thông qua các sự kiện như Đối thoại Minerva, nơi quy tụ các nhà lãnh đạo Kỹ thuật và các nhà thần học để thảo luận về tác động xã hội của Trí tuệ nhân tạo.[16] Những cuộc đối thoại liên ngành như vậy rất quan trọng. Chúng phá vỡ sự ngăn cách thường tồn tại giữa các nhà phát triển Kỹ thuật và các học giả nhân văn. Thật là một dấu hiệu đáng mừng khi thấy các nhà khoa học máy tính, triết gia và giám mục ngồi cùng bàn, vật lộn với các câu hỏi về việc học máy [machine learning] và trách nhiệm đạo đức. Chúng ta càng khuyến khích những cuộc đối thoại này—trong các hội nghị học thuật, các phiên điều trần của chính phủ, các cuộc họp đại kết—chúng ta càng xây dựng được sự hiểu biết chung có thể hướng Trí tuệ nhân tạo đến những mục tiêu tích cực.

Về mặt thần học, chúng ta có thể xem xét sự xuất hiện của Trí tuệ nhân tạo thông qua lăng kính đồng sáng tạo của con người dưới sự hướng dẫn của Thiên Chúa. Khả năng phát minh ra các thuật toán phức tạp và máy móc thông minh của chúng ta là biểu hiện của sự sáng tạo mà Thiên Chúa ban cho nhân loại. Trong sách Sáng thế, con người được giao nhiệm vụ “canh tác và gìn giữ” khu vườn sáng tạo (Sáng thế 2:15); chúng ta cũng được kêu gọi “tham gia một cách có trách nhiệm vào hành động sáng tạo của Thiên Chúa” trên thế giới.[17] Phát triển Kỹ thuật là một cách chúng ta thực hiện ơn gọi đó. Nhưng bất cứ hoạt động nào như vậy đều đi kèm với trách nhiệm đạo đức. Cũng như việc sử dụng sự sáng tạo của chúng ta để xây dựng một cây cầu hay một đột phá y học đều mang những hàm ý đạo đức, việc tạo ra Trí tuệ nhân tạo cũng vậy.

Giáo hội có thể nhắc nhở chúng ta rằng Kỹ thuật không trung lập về mặt đạo đức—nó thừa hưởng các giá trị của những người tạo ra và người sử dụng nó. Do đó, việc xây dựng Trí tuệ nhân tạo không chỉ là một nhiệm vụ kỹ thuật mà còn là một nhiệm vụ đạo đức. Việc định hình theo cách này có thể truyền cảm hứng cho các Kitô hữu trong lĩnh vực Kỹ thuật, coi công việc của họ như một hình thức quản lý hoặc thậm chí làm môn đệ: lập trình để phục vụ Chúa Kitô bằng cách phục vụ người khác. Nó cũng có thể nhắc nhở tất cả chúng ta rằng lòng trung thành cuối cùng của chúng ta không thể nằm ở Kỹ thuật hay tiến bộ vì lợi ích của chính nó, mà là ở Thiên Chúa, Đấng đã giao phó cho chúng ta những món quà này vì lợi ích của những người lân cận.

Cuối cùng, một bước tiến thiết thực là giáo dục và đối thoại ở cấp cơ sở. Các giáo xứ, trường đại học và các nhóm Kitô giáo có thể thúc đẩy các nhóm nghiên cứu tìm hiểu về đạo đức Trí tuệ nhân tạo, đảm bảo rằng cuộc trò chuyện không chỉ giới hạn ở các chuyên gia. Những sáng kiến như vậy giúp giải mã Trí tuệ nhân tạo cho người dân bình thường và xua tan cả sự lạc quan ngây thơ lẫn nỗi sợ hãi thái quá. Chúng cũng trang bị cho những người có đức tin khả năng lên tiếng trước công chúng, ủng hộ một tương lai Trí tuệ nhân tạo phản ảnh các giá trị của chúng ta. Hãy tưởng tượng các ủy ban nhà thờ, giống như các ủy ban công lý xã hội hoặc các nhóm chăm sóc sáng tạo, tập trung cụ thể vào đạo đức Kỹ thuật - giúp cộng đồng luôn được cập nhật và tham gia vào các vấn đề từ quyền riêng tư dữ liệu đến deepfake. Các ủy ban này có thể hợp tác với các công ty Kỹ thuật hoặc nhà hoạch định chính sách địa phương để cung cấp phản hồi và hướng dẫn dựa trên các nguyên tắc đạo đức. Khi các nhà thần học, nhà đạo đức học, kỹ sư và người dùng cùng nhau thiện chí, chúng ta có cơ hội tốt hơn để xây dựng các hệ thống và chính sách Trí tuệ nhân tạo hướng đến sự nâng cao thay vì gây hại.

Kết luận

Sự phát triển nhanh chóng của Trí tuệ nhân tạo mang đến cho chúng ta những lựa chọn sẽ định hình linh hồn của xã hội. Liệu chúng ta sẽ trôi dạt, để tự động hóa và thuật toán quyết định các điều kiện của cuộc sống con người? Hay chúng ta sẽ tiếp cận những công cụ này với sự phân định và ý hướng tính, đảm bảo chúng góp phần vào sự phát triển của con người? Những nguyên tắc siêu việt của Bernard Lonergan—Hãy Ý tứ, Hãy Thông Minh, Hãy Hữu Lý, Hãy Có Trách Nhiệm, Hãy Yêu Thương—mang đến một khuôn khổ vượt thời gian cho chính loại nhận thức này. Chúng nhắc nhở chúng ta rằng dù Kỹ thuật của chúng ta mới mẻ đến đâu, những quy trình cơ bản của sự phán đoán đúng đắn và hành động đạo đức vẫn không thay đổi. Chúng ta phải mở mắt nhìn nhận thực tại, tìm kiếm sự hiểu biết, phán đoán sáng suốt, hành động có đạo đức và tập trung tất cả vào tình yêu thương.

Đối với những người có đức tin, và thực sự là tất cả những người có thiện chí, lời kêu gọi là áp dụng những thói quen của tâm trí và trái tim này vào lĩnh vực Trí tuệ nhân tạo. Điều này có nghĩa là vun đắp một nền văn hóa phân định Trí tuệ nhân tạo trong cuộc sống cá nhân, cộng đồng và các tổ chức của chúng ta. Nó có nghĩa là từ chối bị choáng ngợp bởi những lời hứa hẹn hào nhoáng của Kỹ thuật, và cũng từ chối việc coi thường Kỹ thuật, thay vào đó là đi theo con đường khó khăn hơn của sự tham gia có hướng dẫn. Nó có nghĩa nhấn mạnh rằng nhân loại vẫn là người dẫn dắt, vạch ra lộ trình tiến bộ Kỹ thuật với bàn tay vững chắc trên la bàn đạo đức.

Có rất nhiều lý do để hy vọng. Trên khắp thế giới, các nhà đạo đức học, kỹ sư và các nhà lãnh đạo tôn giáo đang ngày càng hợp tác chặt chẽ để đảm bảo Trí tuệ nhân tạo được phát triển một cách có trách nhiệm. Các chính phủ đang bắt đầu soạn thảo luật về tính công bằng và minh bạch của thuật toán. Các công ty Kỹ thuật, dưới áp lực của công chúng, đang nói nhiều về đạo đức hơn bao giờ hết. Các trường đại học Công Giáo đang phát triển các chương trình sinh thái truyền thông của Giáo hội. Và vô số cá nhân đang học cách sử dụng điện thoại thông minh và trợ lý Trí tuệ nhân tạo của họ một cách nhận thức hơn. Đây là những dấu hiệu cho thấy chúng ta có thể định hình tương lai của Trí tuệ nhân tạo thay vì thụ động chịu đựng nó.

Là các Kitô hữu, chúng ta tiếp cận tương lai với niềm hy vọng, không chỉ nhờ nỗ lực của con người, mà còn bởi vì chúng ta tin tưởng vào một Thiên Chúa dẫn dắt lịch sử. Nếu chúng ta mang những điều tốt đẹp nhất của truyền thống - sự khôn ngoan của nó, sự nhấn mạnh vào phẩm giá của mỗi người, điều răn yêu thương của nó - vào cuộc trò chuyện về Trí tuệ nhân tạo, chúng ta sẽ đóng vai trò như muối và ánh sáng trong thế giới kỹ thuật số. Những thách thức về đạo đức của Trí tuệ nhân tạo, cuối cùng, là sự phản ảnh của những thách thức lâu đời về quyền lực, lòng kiêu hãnh, công lý và lòng bác ái. Các công cụ thì mới, nhưng bi kịch của con người thì không. Trong mọi thời đại, Giáo hội đã được kêu gọi để nhận ra những dấu chỉ của thời đại; ngày nay, một trong những dấu chỉ đó tỏa sáng trong các mạch điện và mã neon. Bằng cách làm theo lời khuyên của Lonergan là phải ý tứ, thông minh, hữu lý, có trách nhiệm và yêu thương, chúng ta có thể đảm bảo rằng ngay cả khi chúng ta đổi mới, chúng ta vẫn không đánh mất nhân tính hay linh hồn của mình.

Thước đo cuối cùng của thành công sẽ không phải là máy móc của chúng ta trở nên thông minh đến mức nào, mà là chúng ta khai thác trí tuệ đó một cách khôn ngoan và yêu thương như thế nào để cải thiện tất cả. Theo lời của một phân tích, chúng ta phải "khẳng định vị thế tối cao của con người" trong việc phát triển và sử dụng Kỹ thuật, hướng tới một thế giới mà Kỹ thuật thực sự phục vụ nhân loại, chứ không phải ngược lại.[18] Với trái tim vững chắc trong tình yêu thương và tâm trí được dẫn dắt bởi sự thật, chúng ta có thể nắm bắt các công cụ của Trí tuệ nhân tạo mà không từ bỏ những gì làm nên con người đích thực của chúng ta. Đó là hy vọng và thách thức trước mắt chúng ta—và nhờ ân sủng của Thiên Chúa, đó là một thách thức mà chúng ta có thể vượt qua vì ích chung.

________________________________________

[1] Victoria Burton-Harris và Philip Mayor, “Bị bắt giữ oan vì nhận dạng khuôn mặt không phân biệt được người da đen,” ACLU, ngày 24 tháng 6 năm 2020.

[2] Lonergan, Bernard J. F. Phương pháp trong Thần học. Tuyển tập các tác phẩm của Bernard Lonergan, (CWL 14), do Robert M. Doran và John D. Dadosky biên tập, Toronto: Nhà xuất bản Đại học Toronto, 2017, trang 22-23.

[3] Steven Umbrello, “Điều hướng Trí tuệ nhân tạo với các nguyên tắc siêu việt của Lonergan,” Evangelization & Culture Online, ngày 25 tháng 4 năm 2024.

[4] Sđd.

[5] Casey Moffitt và Linsey Maughan, “Thiên kiến trong bong bóng: Nghiên cứu mới cho thấy thuật toán lọc tin tức củng cố thiên kiến chính trị”, Illinois Tech, ngày 1 tháng 11 năm 2021.

[6] Jeffrey Dastin, “Thông tin chi tiết: Amazon loại bỏ công cụ tuyển dụng Trí tuệ nhân tạo bí mật cho thấy thiên kiến đối với phụ nữ”, Reuters, ngày 11 tháng 10 năm 2018.

[7] NAACP, Tóm tắt vấn đề về Trí tuệ nhân tạo trong Cảnh sát dự đoán, không có ngày.

[8] Steven Umbrello, “Điều hướng Trí tuệ nhân tạo với các nguyên tắc siêu việt của Lonergan”, Sđd.

[9] Sđd.

[10] Sđd.

[11] Sđd.

[12] NAACP, Tóm tắt vấn đề về Trí tuệ nhân tạo trong Cảnh sát dự đoán, Sđd.

[13] Steven Umbrello, “Điều hướng Trí tuệ nhân tạo với các nguyên tắc siêu việt của Lonergan”, Sđd.

[14] Deborah Castellano Lubov, “Đức Giáo Hoàng Phanxicô kêu gọi sử dụng trí tuệ nhân tạo một cách có đạo đức”, Vatican News, ngày 27 tháng 3 năm 2023.

[15] Sđd.

[16] Sđd.

[17] Sđd.

[18] Steven Umbrello, “Điều hướng Trí tuệ nhân tạo với các nguyên tắc siêu việt của Lonergan”, Sđd.

_________________________________

(*) Taylor Black dẫn dắt các chương trình chiến lược tại Văn phòng Giám đốc Kỹ thuật (CTO) của Microsoft, nơi ông khám phá các ranh giới của đổi mới sáng tạo và tinh thần kinh doanh của doanh nghiệp. Với bằng cấp cao về triết học và luật, ông kết hợp sự nghiêm khắc về mặt trí tuệ với tính thực tiễn trong vai trò giảng viên tại Trường Kinh doanh Foster thuộc Đại học Washington và ứng viên phó tế tại Giáo phận Công Giáo Byzantine ở Phoenix.